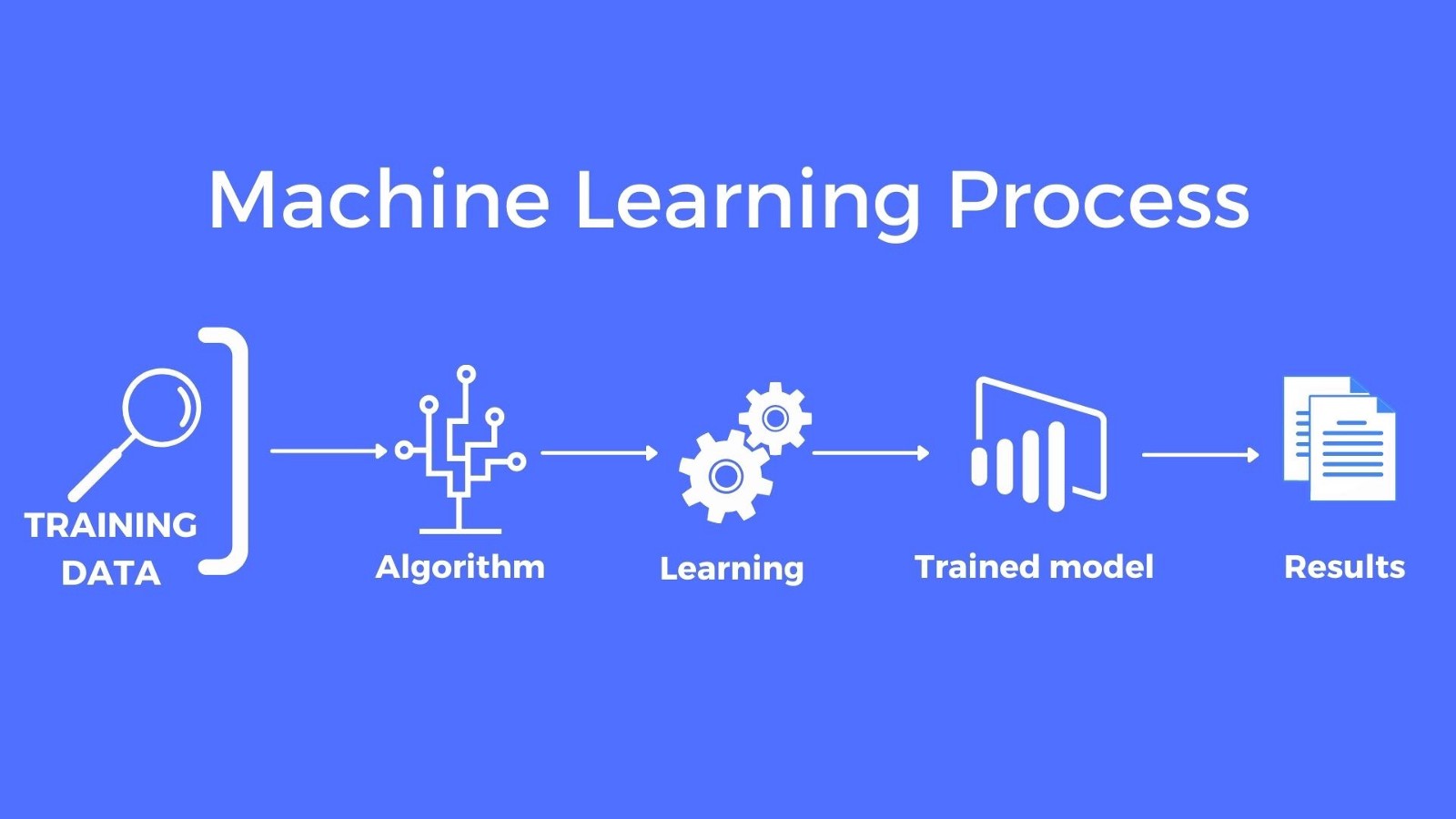

Cada vez mais democrática e acessível, não é novidade que a inteligência artificial tem ganhado espaço no dia a dia das pessoas, mas a utilização de ferramentas como essa não é recente. Há anos o comércio eletrônico tem usufruído da tecnologia para ser assertivo em suas recomendações e vendas. A ascensão do uso de dados de navegação é conhecida como BigData e é feito com a tecnologia de “cookies” e “tracking”, onde o algoritmo extrai informações da utilização em sites e aplicativos do usuário.

Geolocalização e o seu uso para apoiar a tomada de decisões em aplicações

Muitas vezes quando gostaríamos de ir para um lugar que não conhecemos, é muito comum utilizar algum aplicativo que encontre a menor rota de acordo com o que for mais importante para quem for realizar esse percurso. Entretanto, apesar de ser cada vez mais comum situações como essa, muitas pessoas ainda não sabem como a geolocalização funciona e em como ela está impactando no seu dia a dia.

Continue lendo “Geolocalização e o seu uso para apoiar a tomada de decisões em aplicações”Métodos de comunicação Arduino e servidores de aplicação

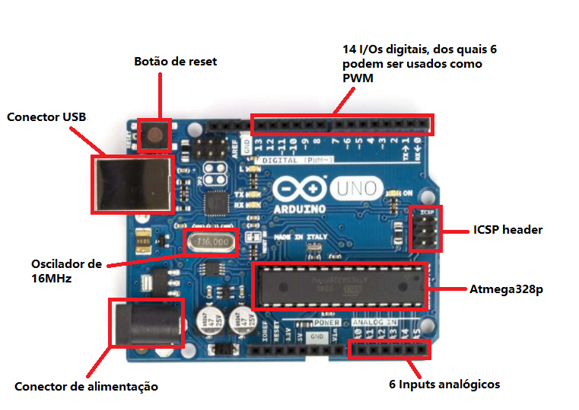

O que é um Arduino?

O Arduino é uma placa de prototipagem eletrônica que pode ser usada para desenvolver projetos de automação residencial, como desligar automaticamente as luzes, ajustar a temperatura de um ar-condicionado e muito mais. O melhor de tudo é que essa tecnologia é de código aberto, o que significa que é acessível a qualquer pessoa.

Continue lendo “Métodos de comunicação Arduino e servidores de aplicação”Métodos de autenticação de APIs

O que a autenticação faz?

A Autenticação na API Rest permite que se obtenha autorização para se comunicar e realizar emissão, recebimento e importação de DFes (Documentos Fiscais Eletronicos) de uma empresa. Antes de utilizar um dos serviços da API, o usuário deve obter um x-auth-token.

Frameworks NODE JS – Adonis X Nest

Este artigo realizará uma breve análise entre os dois maiores frameworks Node.js da atualidade, Adonis.js e Nest.js, descrevendo suas características e melhores aplicações para cada framework.

Continue lendo “Frameworks NODE JS – Adonis X Nest”Comparativos de Bancos Relacionais: SQL Server, PostgreSQL e MySQL

Entre os três bancos de dados o MySQL é o líder definitivo, ele é utilizado pelas empresas: Google, LinkedIn, Amazon, Netflix e Twitter. O PostgreSQL é conhecido por suportar muitos tipos de dados e finalmente o SQL Server que se trata de uma “solução comercial”.

Continue lendo “Comparativos de Bancos Relacionais: SQL Server, PostgreSQL e MySQL”Aplicações para documentações de APIs

Em um mundo cada vez mais integrado e conectado, pode-se dizer que atualmente encontram-se diversos serviços que se comunicam entre si, trazendo uma vasta quantidade de funcionalidades e recursos que aprimoram a experiência de um usuário final, na utilização de algum software ou serviço.

Continue lendo “Aplicações para documentações de APIs”Amazon SES: Entenda as vantagens e desvantagens de se usar

No mundo atual, manter um contato contínuo com clientes e parceiros pode ser uma tarefa difícil, ainda mais para grandes empresas. Uma forma de realizar essa comunicação é utilizando e-mails. Porém, o monitoramento para que eles realmente cheguem a um destinatário pode ser difícil e até mesmo de alto custo. Assim, a utilização de um meio externo para realizar esse trabalho é uma ótima opção.

Continue lendo “Amazon SES: Entenda as vantagens e desvantagens de se usar”Banco de Dados Baseado em Grafos e suas Principais Características

O banco de dados baseado em grafos é relativamente simples de ser desenhado, diferente do banco relacional onde o modelo básico são tabelas e as suas relações, o modelo básico desse tipo de banco são os grafos, onde podemos inserir um dado sem se preocupar quais relacionamentos ele possuirá, pois, essa relação acontece de forma mais simples.

Continue lendo “Banco de Dados Baseado em Grafos e suas Principais Características”Gamificação: Como tornar seu aplicativo mais atrativo

Atualmente é cada vez mais difícil capturar a atenção de uma pessoa em um aplicativo, pois existem diversos fatores que tiram a atenção do usuário quando ele está usando algum aplicativo que não o engaje, não pegue a atenção plena do usuário, alguns exemplos são as notificações de outros aplicativos, como por exemplo alguma marcação em publicação em redes sociais, se o usuário não estiver engajado no aplicativos em questão ele sairá para ver a notificação.

Continue lendo “Gamificação: Como tornar seu aplicativo mais atrativo”5 Bibliotecas open source para reconhecimentos de objetos e OCR

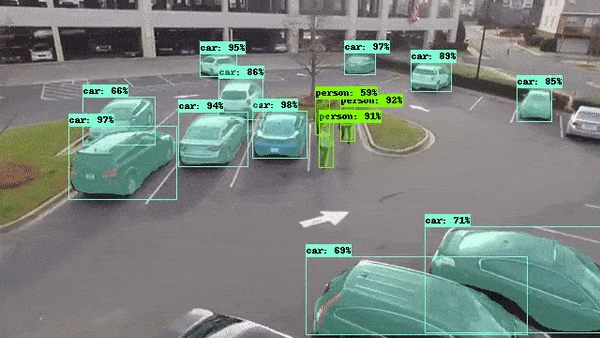

Quando desejamos extrair informações de imagens ou vídeos, a maior dificuldade está no reconhecimento das informações, separar um texto com uma imagem no fundo pode parecer uma tarefa muito difícil. Porém não é, hoje possuímos muitas bibliotecas que podem nos auxiliar nestas tarefas e fazer isto com apenas algumas linhas de código. E o melhor de tudo, de graça.

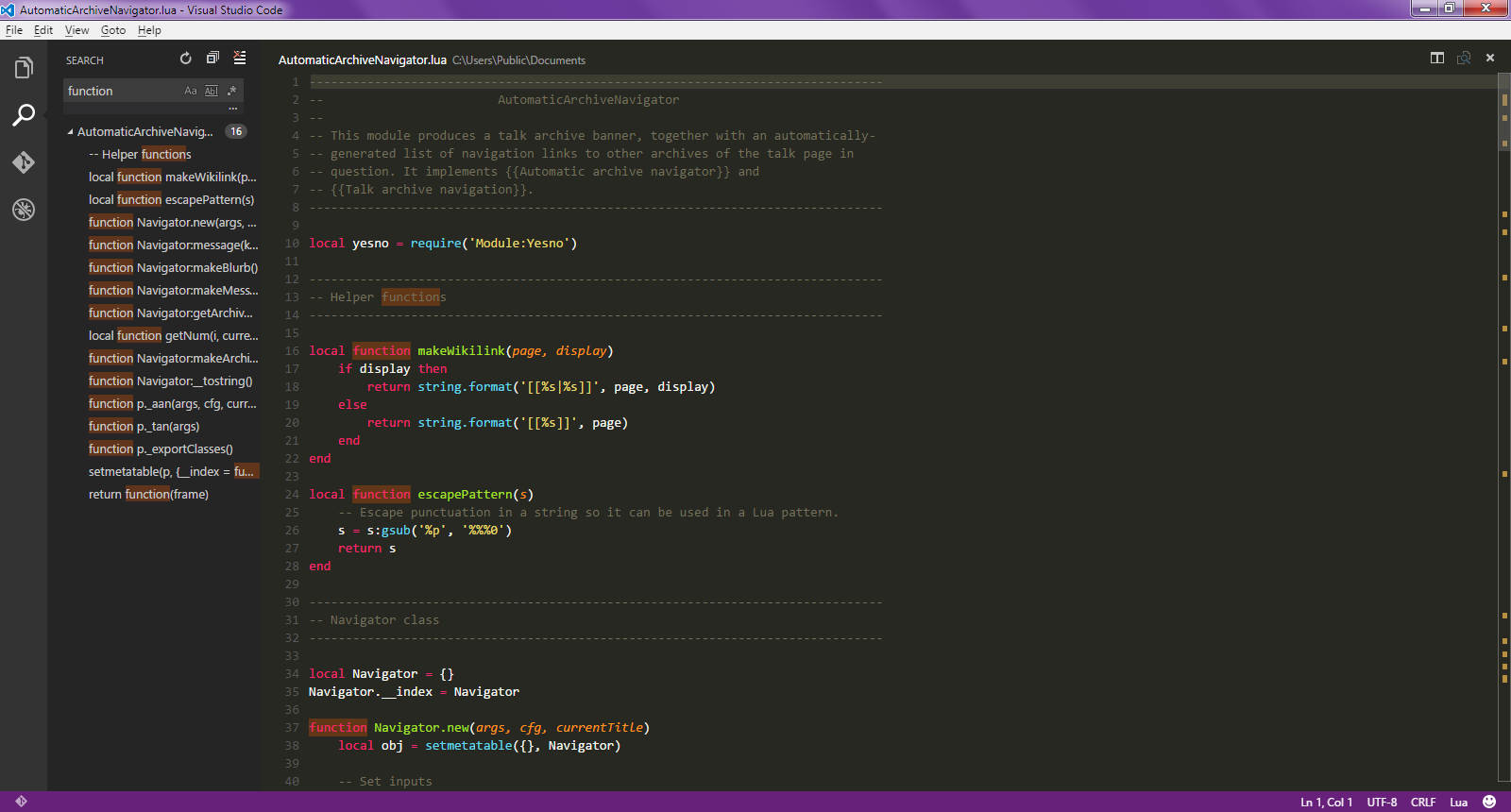

Continue lendo “5 Bibliotecas open source para reconhecimentos de objetos e OCR”IDEs para desenvolvimento em Java Script

Introdução

Os IDEs vêm com muitos recursos extras, como por exemplo o preenchimento automático de texto, podendo dar mais flexibilidade ao usuário. Com a ajuda de IDEs, é possível aumentar a produtividade. Existem diversos IDEs na Internet e muitos deles são de código aberto.

Continue lendo “IDEs para desenvolvimento em Java Script”NodeJS vs Go

Nos dias atuais e na era da informação, se torna cada vez mais fácil ter acesso a um bom conteúdo para estudar e se aperfeiçoar. Isso possibilitou que nós, desenvolvedores, tenhamos uma grande quantidade de tecnologias à nossa disposição para solucionar os problemas corriqueiros de nosso dia a dia. Este texto tem como objetivo comparar duas excelentes tecnologias que empoderam milhões de desenvolvedores ao redor do mundo. Durante este post, irei abordar diversos pontos que considerei importantes para a escolha de uma stack e espero que talvez, encurte a sua jornada.

Continue lendo “NodeJS vs Go”Arquitetura Serverless: O que você precisa saber

Você já imaginou executar suas funções de backend sem possuir um servidor? A arquitetura serverless nos permite essa facilidade.

No entanto, como o nome da arquitetura sugere (serverless, do inglês, sem servidor), existe sim um servidor executando tais funções, ele somente não é gerenciado por você, mas pela plataforma cloud no modelo FaaS (Function as a Service) que você irá utilizar, como por exemplo Amazon Web Services (AWS), Microsoft Azure, Google Cloud, entre outras. Com isso, evita-se a configuração de servidores complexos e/ou ambientes isolados como os containers.

Continue lendo “Arquitetura Serverless: O que você precisa saber”Clusterização de dados K-Means na biblioteca scikit-learn

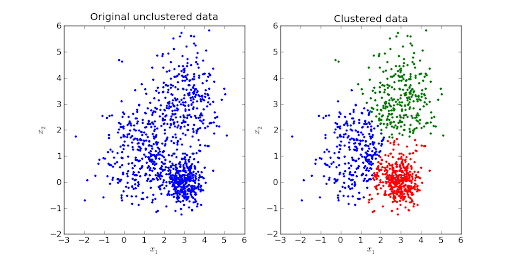

A clusterização de dados é uma técnica que visa fazer agrupamentos automáticos de dados, levando em consideração o grau de semelhança, tem por objetivo agrupar através de aprendizado não supervisionado casos de uma base em k grupos, também denominados clusters, a classificação de dados surgiu com a necessidade de separar os dados em determinados grupos com semelhanças de atributos.

Existem diferentes formas de realizar a clusterização de dados, o scikit-learn por exemplo, é uma biblioteca para a linguagem python que disponibiliza de vários algoritmos para clusterização de dados, um dos mais conhecidos é o algoritmo K-Means.

Continue lendo “Clusterização de dados K-Means na biblioteca scikit-learn”